iCampusWildau

ROS-E - Ein sozialer Roboter

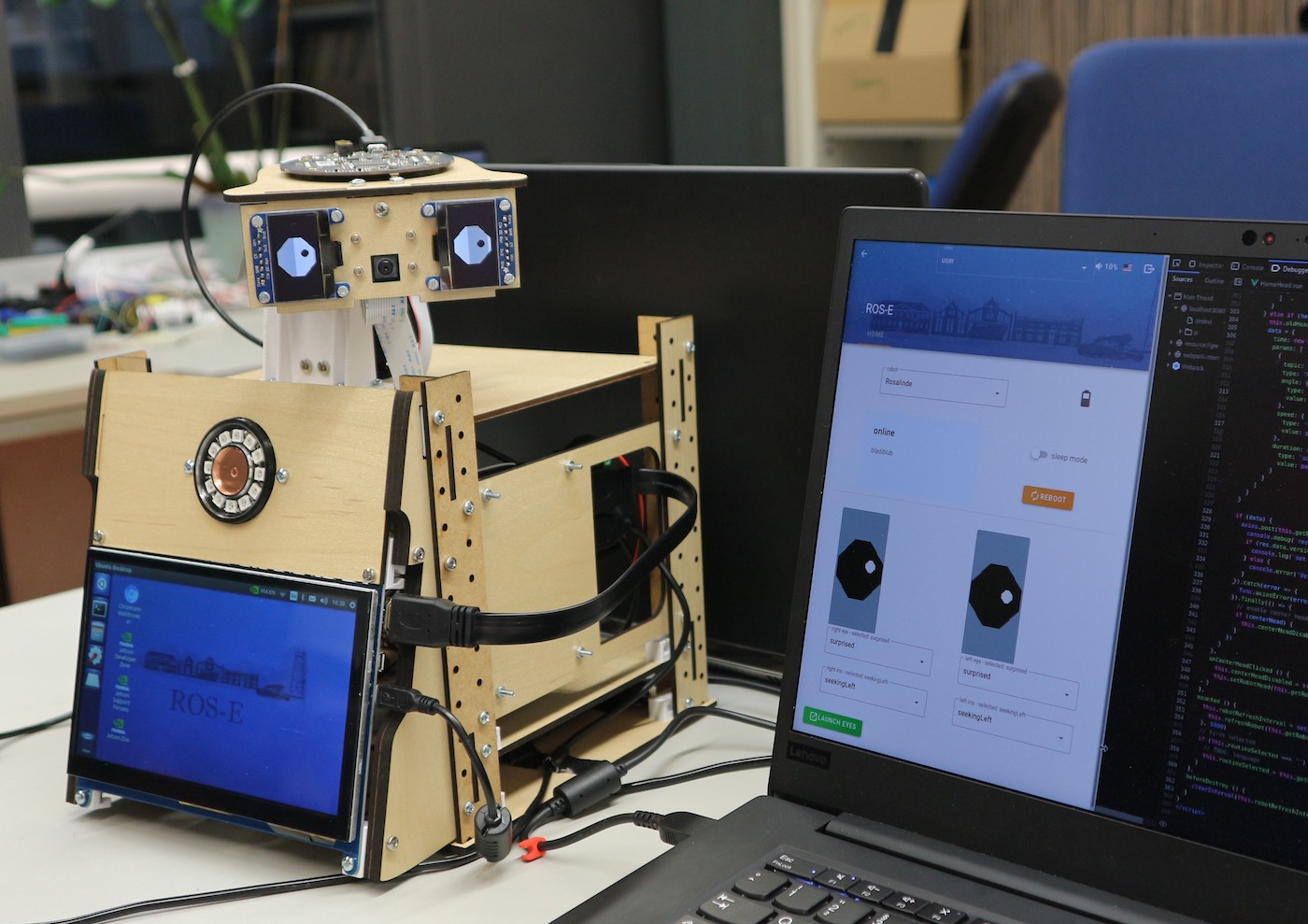

Das ist ROS-E.

ROS-E wurde von uns, dem RobotikLab-Team der TH Wildau, selbst geplant, designt, produziert und entwickelt. Im Studiengang Telematik und in den Schülerlaboren werden seit einigen Jahren Roboter wie der NAO oder der kleine NIBO verwendet, um zu lehren, wie Roboter programmiert werden. Die Studierenden können dabei eigene Ideen für Projekte entwickeln und umsetzen. Dadurch kommen jedes Jahr viele schöne Projekte zustande, die aber häufig durch die Roboter bzw. deren Software eingeschränkt werden. Die Idee, einen eigenen Roboter zu bauen, bei dem alle Funktionen und auch der Preis des Roboters selbst beeinflusst werden können, wurde immer verlockender.

Einen eigenen Roboter bauen? Aber wie?

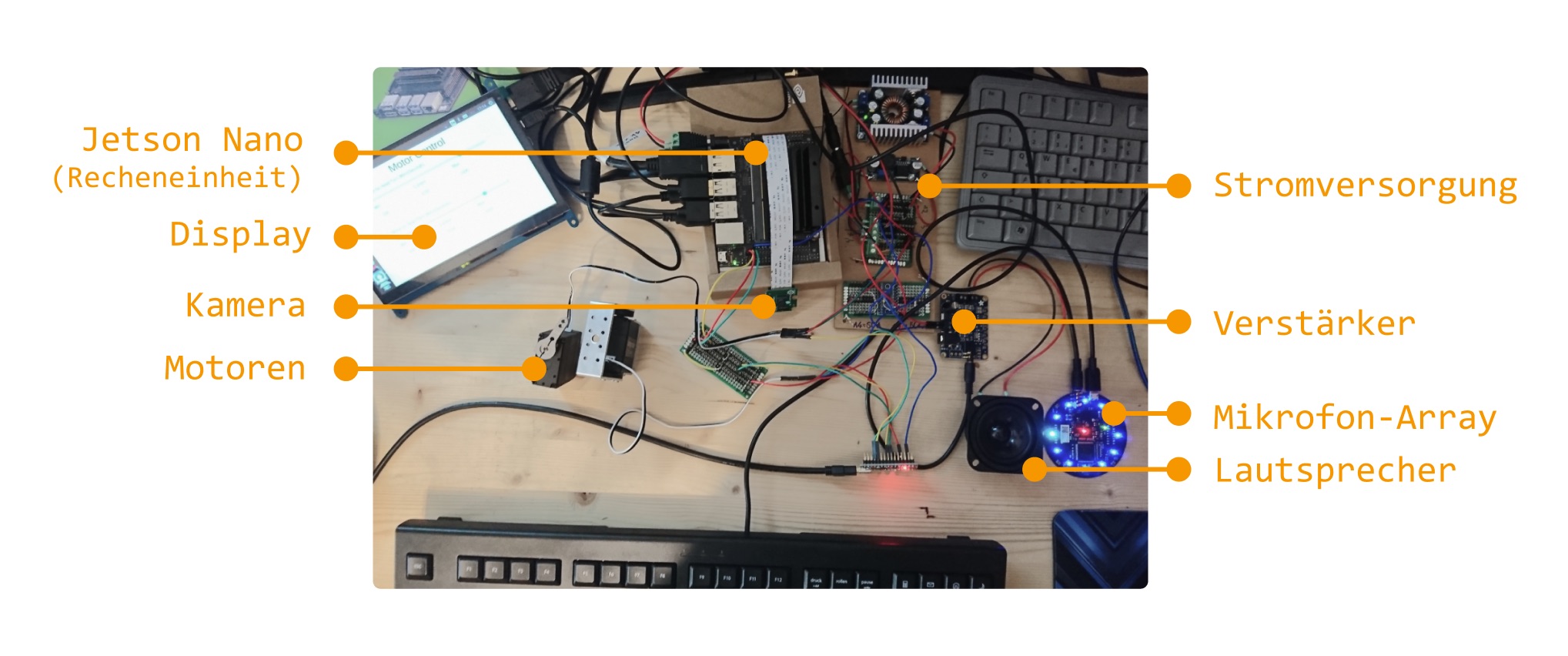

Aus dieser Idee wurde 2019 mit der Bachelorarbeit von Valentin

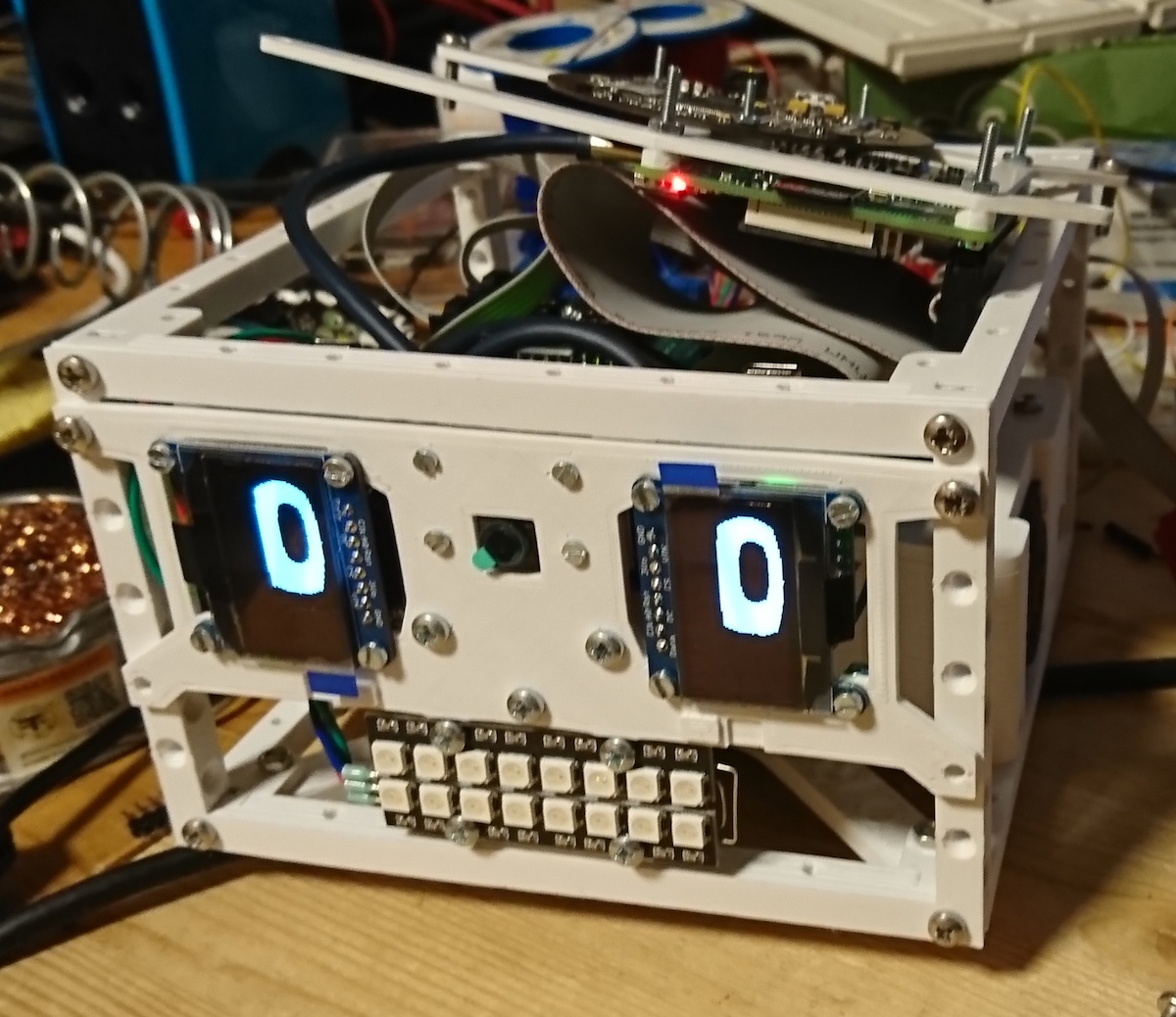

der erste Schritt auf dem Weg zu einem eigenen Roboter gewagt. Damals war ROS-E noch ein kleiner Haufen aus Hardware-Komponenten.

In diesem Zustand waren die grundlegenden Komponenten wie:

- Stromversorgung

- Sensoren (Kamera, Mikrofon-Array, ...)

- Motoren und die

- Recheneinheit

zusammengeschlossen. Im nächsten Schritt mussten alle Komponenten auch mit Software verbunden werden, sodass die Motoren gesteuert und Geräusche erkannt werden konnten. Aber viel mehr konnte ROS-E auch noch nicht tun.

Ein erstes Design

Damit war es an der Zeit, den "Hardware-Haufen" in eine Roboter-Form zu bringen und natürlich einen Namen zu vergeben. Alle Teile wurden verkabelt und in ein Gehäuse aus gelasertem Holz verpackt:

Die Ähnlichkeit zu einem gewissen Roboter aus dem Film WALL-E ist rein zufällig entstanden, war aber die Idee für den Namen ROS-E. Das ROS stammt von der Abkürzung für das Roboter Operating System, das Betriebssystem mit dem ROS-E arbeitet. Damals war das Design noch als Kopf und Körper mit einem Display geplant. Dieses Design wurde aus mehreren Gründen später nochmal überarbeitet.

Wie erweckt man einen Haufen Hardware zum Leben?

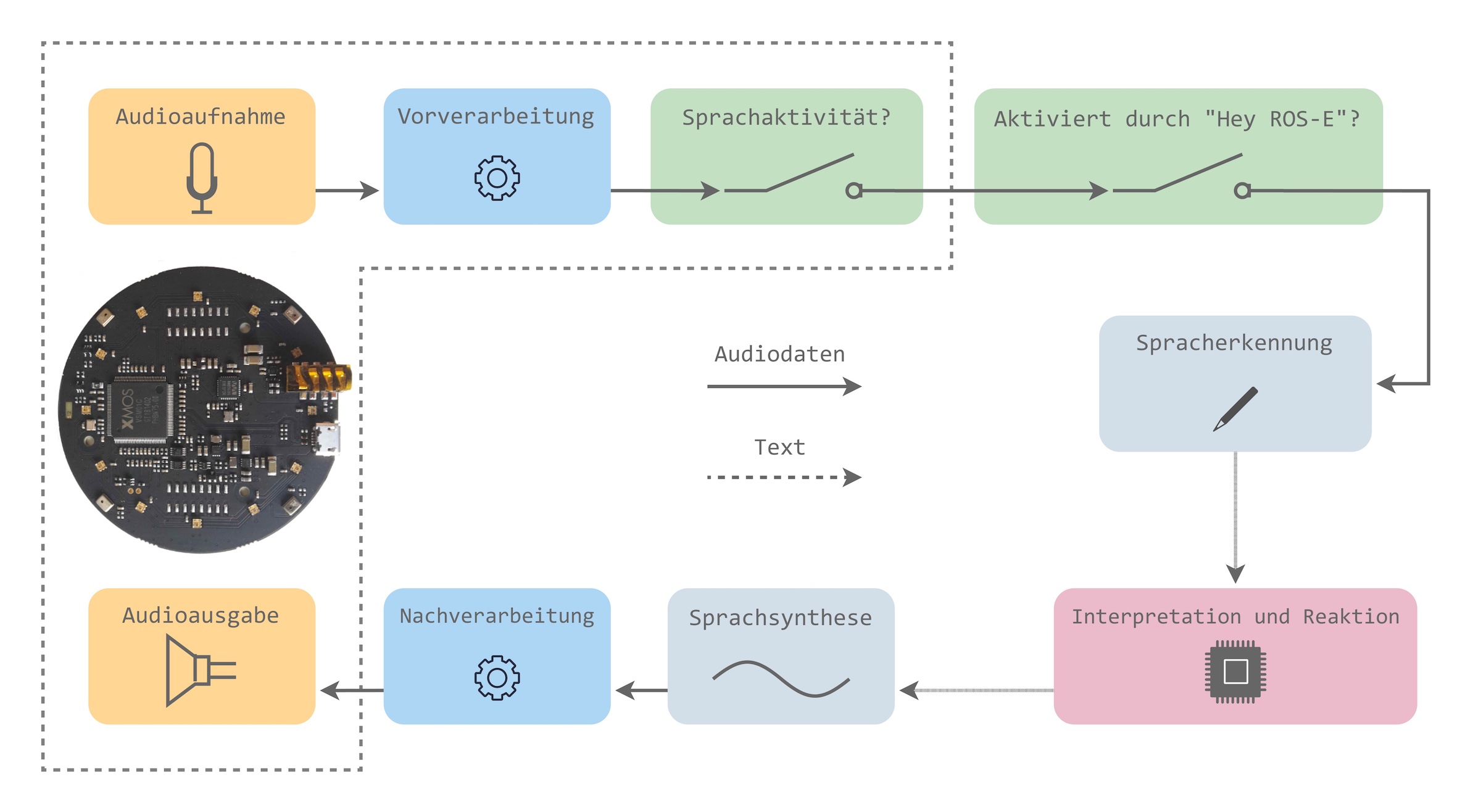

Ein großer Teil der Interaktion mit ROS-E findet über die Stimme (vom Menschen und von ROS-E) statt. Dahinter steckt ein komplexes System, das mit Hilfe von Künstlicher Intelligenz mehrere knifflige Teilaufgaben wie zum Beispiel die folgenden löst:

- Wie erkennt ROS-E, dass jemand sie mit “Hey ROS-E” angesprochen hat?

- Wie kann sie verstehen, was sie tun soll, wenn jemand sagt: “Kannst du ein Foto versenden?”

- Und wie kann ROS-E überhaupt mit einer menschlichen Stimme sprechen?

Das Mikrofon-Array von ROS-E hat nicht nur eines, sondern 4 Mikrofone, weil mit ihnen die Richtung von Geräuschen errechnet werden kann. Außerdem kann in eine bestimmte Richtung gelauscht werden, indem alle anderen Nebengeräusche unterdrückt werden. Nach dieser Vorverarbeitung werden die Audio-Daten analysiert und festgestellt ob sie Sprache oder nur Geräusche enthalten. Die Abschnitte der Daten, die Sprache enthalten, werden an ein Künstliches Neuronales Netz weitergegeben.

Wer sich darunter nicht wirklich etwas vorstellen kann, findet auf dieser Seite eine interaktive Einführung in die Arbeitsweise von Künstlichen Neuronalen Netze: knn.innohub13.de.

Das Künstliche Neuronale Netz von ROS-E prüft, ob das was gesagt wurde das sogenannte "Keyword" oder "Wake-Word" enthält. Im Fall von ROS-E haben wir dieses Wort (oder die Phrase) auf "Hey ROS-E" festgelegt und das Netz damit trainiert.

Nachdem ROS-E das Keyword erkannt hat, lauscht sie auf den Befehl oder die Frage, die die Benutzer:innen anschließend stellen können. Die Audiodaten werden mit Hilfe eines weiteren Künstlichen Neuronalen Netzes in einen Text umgewandelt, den ROS-E anschließend auswerten kann. Mit diesen Themen der Sprachverarbeitung beschäftigt sich Tobias, seit er in seiner Masterarbeit ein solches System entwickelt hat.

ROS-E hat jetzt also aus den Audio-Daten einen Befehl in Form von Text „aufgeschrieben“. Dieser Text kann als nächstes ausgewertet werden. Diese Auswertung könnte zum Beispiel darin bestehen, den Befehl "Mach bitte das Licht an!" mit den verfügbaren Aktionen abzugleichen und auszuführen. Für die Erkennung solcher Befehle ist ein weiteres Künstliches Neuronales Netz zuständig.

ROS-E muss aber nicht nur stumm Befehle ausführen, sondern kann auch mit Sprache antworten. Dazu kann ein Entwickler oder eine Entwicklerin zum Beispiel als Antwort ein "OK" festlegen. Dieser Text wird dann mit Hilfe eines weiteren Netzes in eine künstliche Stimme synthetisiert, wie beim Mixen von Musik noch nachverarbeitet und schließlich über die Lautsprecher ausgegeben.

Wie funktioniert das mit der Sprachverarbeitung genauer?

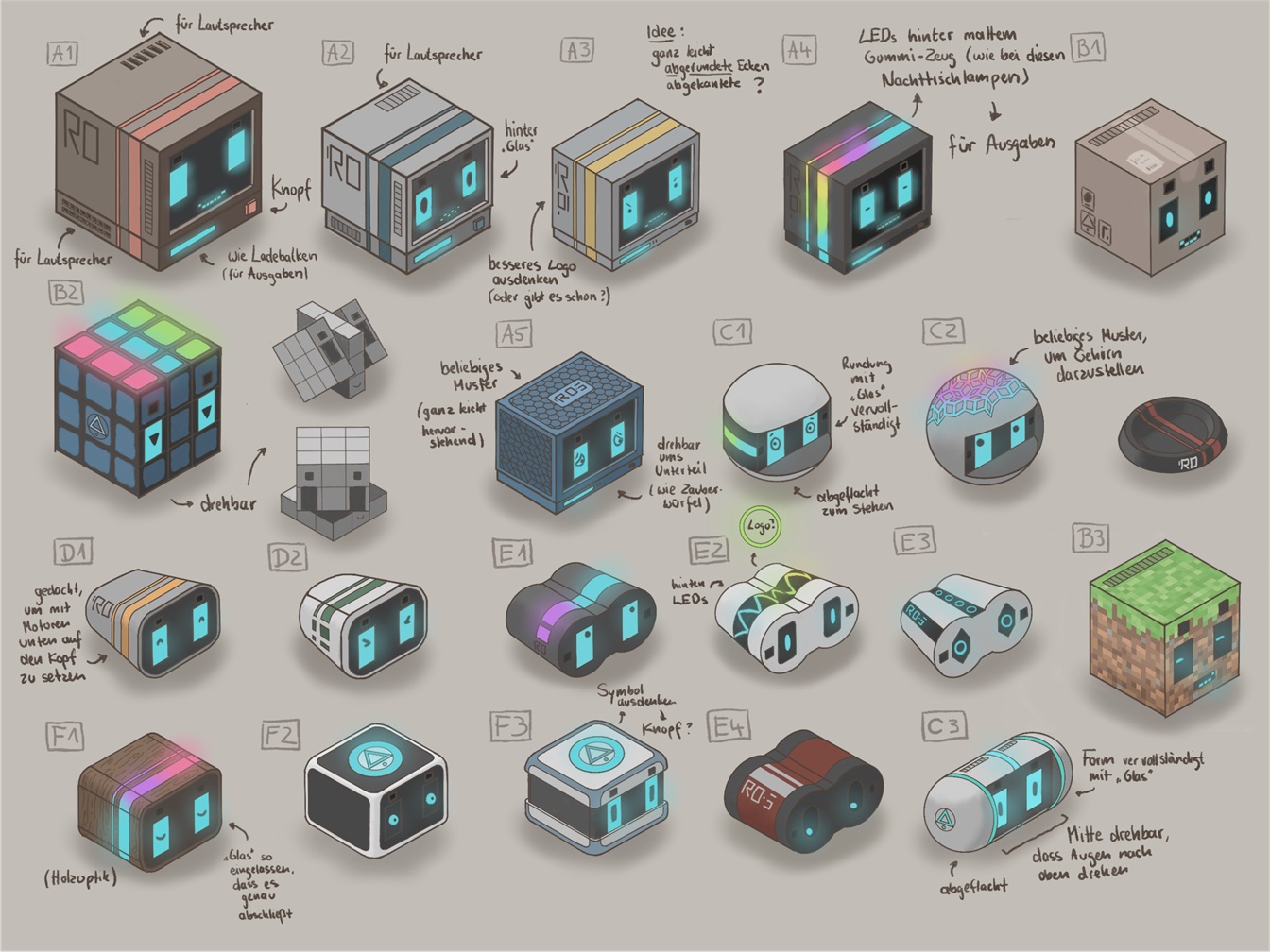

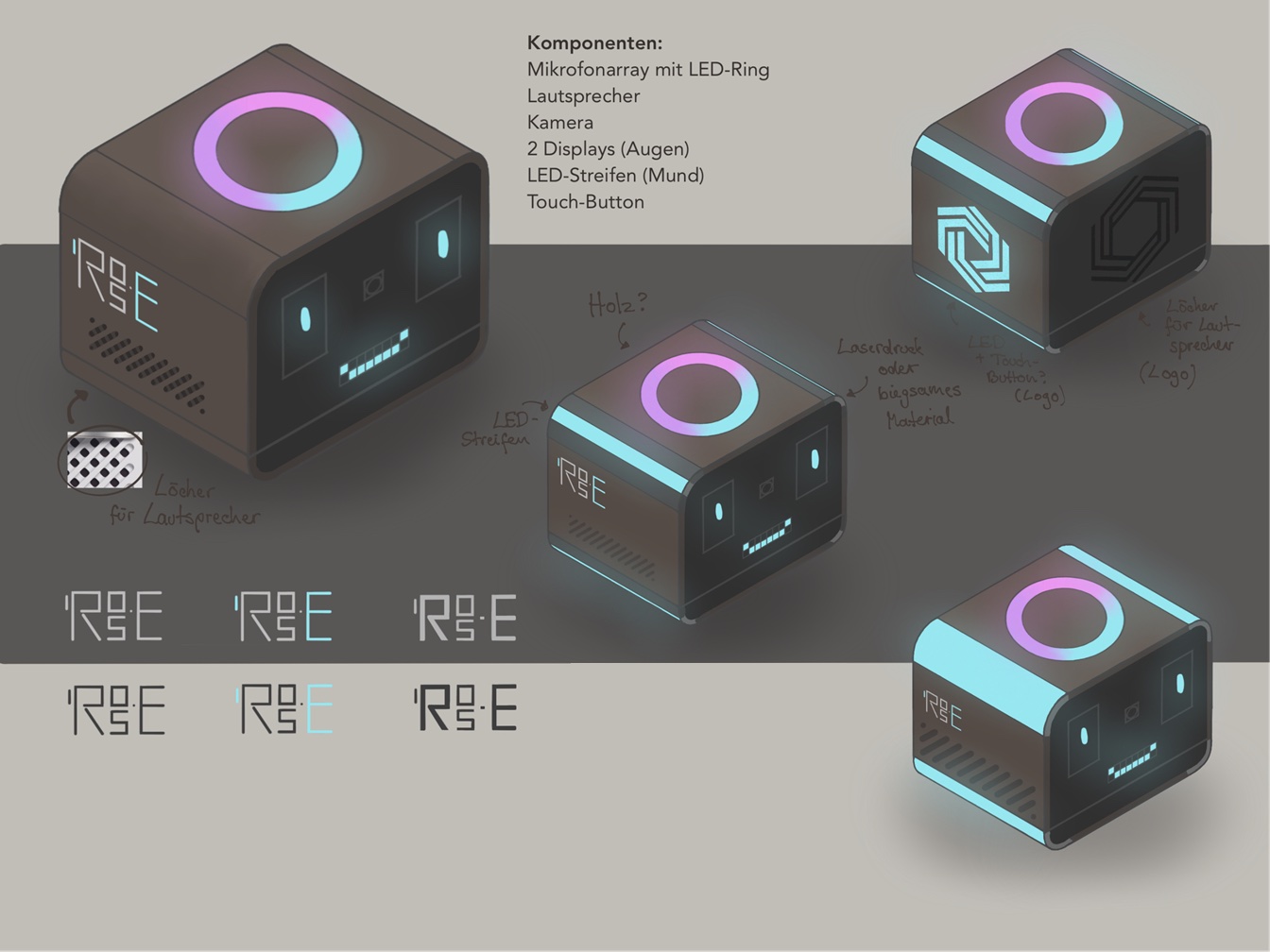

Ein zweites Design und mehr ROS-Es

Während ROS-E immer mehr "geistige" Fähigkeiten bekam, war es an der Zeit, über ein neues Design nachzudenken. Der halb offene Kasten aus Holz war zu groß und unhandlich, um ihn Kindern oder älteren Menschen anzubieten. Um ROS-E so klein wie möglich zu gestalten, musste das große Display weggelassen werden. Dafür wurde später ein System eingerichtet, mit denen man die Apps auf ROS-E auf einem zusätzlichen Tablet anzeigen kann. Die Ideen für mögliche Formen sind hier zu sehen:

Es wurde ziemlich schnell klar, welche Idee weiter verfeinert werden sollte:

Ein Bild von einem Design zu haben, ist schon mal sehr hilfreich, aber der wirklich schwere Teil war jetzt, dieses Design auch so umzusetzen, dass alle Hardware-Komponenten sinnvoll in die Hülle passen, alles verkabelt werden kann, der Standfuß sich bewegen kann, das Ganze gut gekühlt werden kann.

Als es dann endlich so weit war und die erste ROS-E mit dem 3D-Drucker gedruckt und zusammengebaut war, sah das Innenleben so aus:

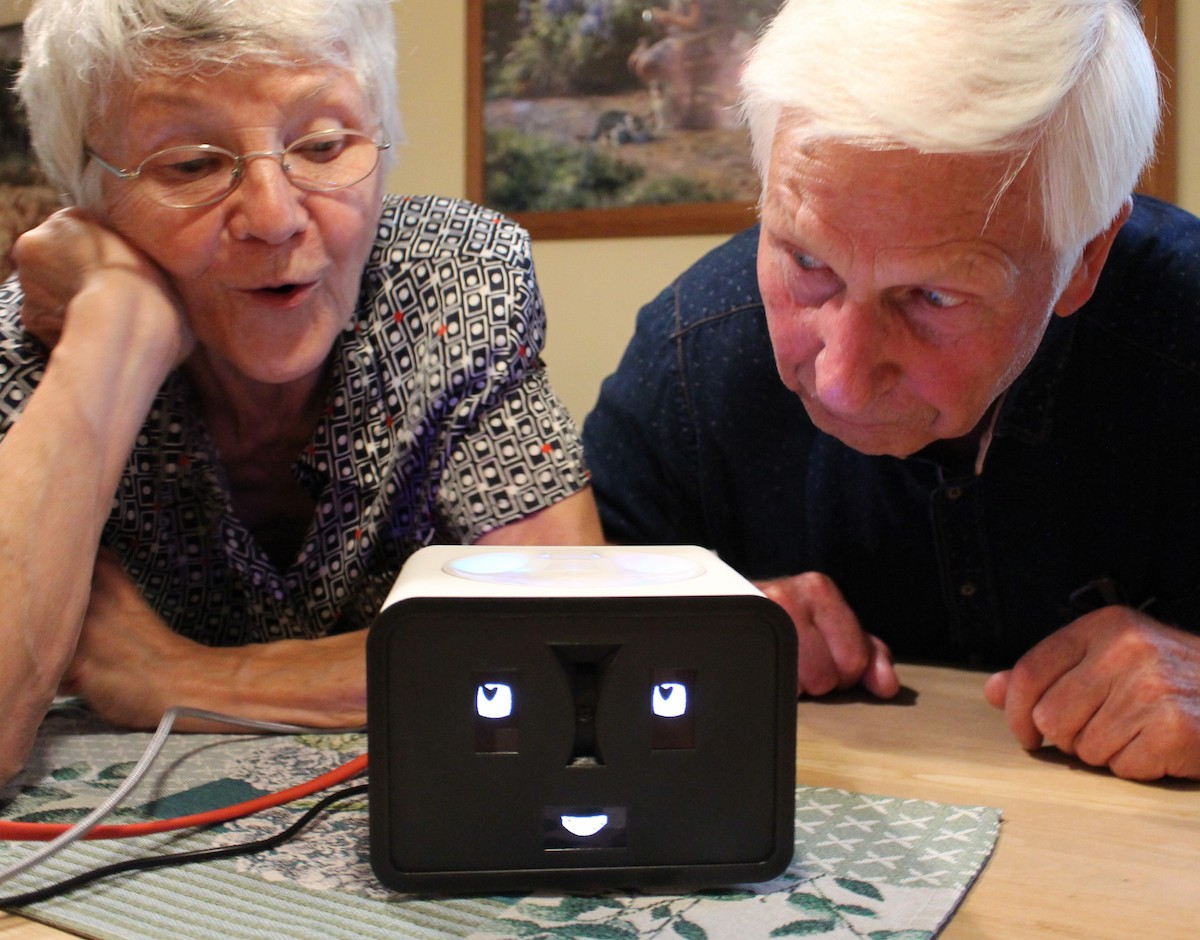

Naja...nicht jede Idee sieht später so niedlich aus wie auf einer Zeichnung.... Der gruselige Skelett-Mund wurde also ziemlich schnell gegen ein weiteres Display wie das der Augen ausgetauscht. Als dann die Hülle mit dem Holz endlich fertig war, war es kaum zu glauben, dass ein kleines Bild auf einer Zeichnung jetzt Wirklichkeit geworden war:

Die Aufgaben von ROS-E

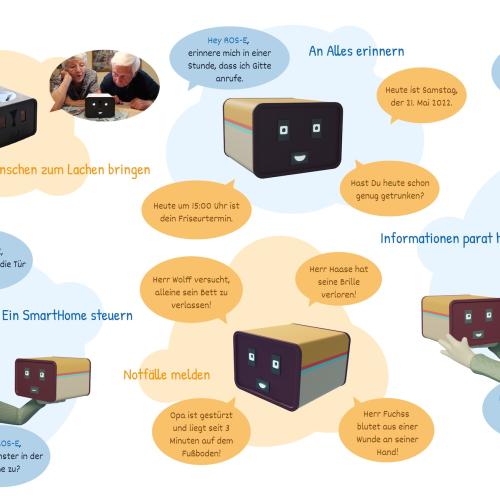

Die vage Idee, einen eigenen Roboter zu entwickeln, ist zwar inzwischen schon ein greifbarer Prototyp, die Arbeit mit ROS-E fängt allerdings erst richtig an. Roboter werden eigentlich immer mit dem Ziel gebaut, Menschen bei Aufgaben zu unterstützen. Manchmal ist die Aufgabe eines Roboters nur, den Menschen zu unterhalten, aber ROS-E kann mit ihren Fähigkeiten viel mehr tun. Aber was kann sie nun eigentlich tun?

Bis jetzt erscheint ROS-E bestimmt sehr ähnlich zu anderen Sprachassistenten wie Alexa & Co. Dieser Vergleich ist vermutlich hilfreich, um eine Vorstellung davon zu haben, wie die Interaktion mit ROS-E ungefähr aussehen könnte. Aber der Vergleich ist nicht ganz richtig, denn ROS-E hat einige wichtige Eigenschaften, die andere Sprachassistenten nicht haben.

Die vielleicht offensichtlichste ist ihr Gesicht. ROS-E kann Emotionen zeigen, die neben der Sprache ein sehr wichtiges Mittel der menschlichen Kommunikation sind. Aber viel wichtiger ist, dass sie auch Emotionen in Menschen auslösen kann. Es ist auf Bildern schwer zu zeigen, aber wenn wir ROS-E programmieren, passiert es uns nicht selten, dass wir selbst lächeln müssen, wenn sie uns frech anzwinkert. Gerade für die Kommunikation mit älteren Menschen kann ROS-E hoffentlich eher das Gefühl eines lebendigen Wesens erzeugen, als das einer sprechenden Box.

Wir haben ROS-E aber nicht nur mit Mikrofonen ausgestattet, sondern auch mit einer Kamera. Sie soll nicht nur hören, sondern auch sehen können. Auch Menschen nehmen einen sehr großen Teil der Informationen über die Augen auf. Mit ihrer Kamera ist ROS-E in der Lage zum Beispiel Gesichter und Gesten zu erkennen. Das könnte sehr wichtig werden, wenn Patient:innen nicht in der Lage sind, zu sprechen. Natürlich ist die Kommunikation mit Gesten möglicherweise eingeschränkter als mit der Stimme.

Da ROS-E nicht nur hören, sondern auch sehen kann, forschen wir derzeit an einem System, das beide „Sinne“ ähnlich wie im menschlichen Gehirn verbinden und so die aktuelle Situation einschätzen kann. Damit kann ROS-E nicht mehr nur auf Sprachbefehle reagieren, sondern für die aktuelle Situation eine passende Aktion auswählen. So kann sie lernen, in welcher Situation sie selbstständig einen Notfall melden oder fragen soll, ob sie das Licht einschalten kann. Auch die Situationserkennung arbeitet mit einem Künstlichen Neuronalen Netz und wird von Lara entwickelt, seit sie ihre Masterarbeit zu diesem Thema geschrieben hat.

Projekte mit ROS-E

Wir entwickeln ROS-E inzwischen auch nicht mehr nur in unserem Labor, sondern haben Projekt-Partner aus der „echten“ Welt gewinnen können. In der Bachelorarbeit von Patrick Schlesinger wird daran gearbeitet, dass über ROS-E automatisierte Türen gesteuert werden können. Diese Idee wird gemeinsam mit den Kliniken der Beelitz-Heilstätten umgesetzt, wo ROS-E in Zukunft den querschnittsgelähmten Patient:innen helfen soll, sich an ihre Situation zu gewöhnen.

Zusammen mit der sense.AI.tion GmbH aus Wildau arbeitet das RobotikLab zurzeit an einem Sprachassistenten für Pflegekräfte und zu pflegende Menschen. Das Ziel dabei ist es, dass vor allem die Menschen, die wenig Erfahrung mit Technik haben, ihre natürliche Sprache nutzen können, um mit Geräten wie ROS-E zu kommunizieren.

Im Frühling 2022 haben wir als Team ROS-E-beim innofab_ Ideenwettbewerb teilgenommen. Am 14.06. haben wir unsere Idee, mit ROS-E den Alltag von Pflegekräften und Pflegebedürftigen zu unterstützen, vor einer Jury und einem Publikum vorgestellt. Wir haben uns sehr gefreut, den 1. Platz und den mit dem 2. Platz geteilten Publikumspreis gewonnen zu haben. Das hat uns die Bestätigung gegeben, dass unsere Idee auch viele andere Menschen begeistert und wichtige Probleme lösen könnte.

Mehr über die spannenden Ideen der anderen Teilnehmer gibt es hier: https://innohub13.de/innofab-gewinnerinnen-2022/.

Das PROFIT-Projekt “Natürlichsprachliche Dialogassistenten in der Pflege” wird gefördert aus Mitteln des Europäischen Fonds für regionale Entwicklung (EFRE).

Projektlaufzeit: 01.07.2020 – 31.12.2022.

Weitere Informationen zu dem Projekt gibt es hier:

https://icampus.th-wildau.de/cms/roboticlab/projekte/natuerlichsprachliche-dialogassistenten-der-pflege

Stunden- und Prüfungsplan

Der Stunden- und Prüfungsplan der TH Wildau ist als neue Anwendung in einer optimierten und nutzerfreundlicheren Darstellung entwickelt worden.

Mit Rollenverwaltung und vielen Features sind die Stundenplandaten sowohl als intergrierte Ansicht auf der TH-Website als auch in der Unidos-App verfügbar.

Die neue Version des Stundenplan stellt folgende Funktionen bereit:

- Tages- und Wochenansicht

- Login-Funktion und persönliche Ansicht

- Export des Stundenplan

Haben Sie Anmerkungen oder Verbesserungswünsche? Geben Sie uns Feedback und helfen uns, die Anwendungen noch besser zu machen.

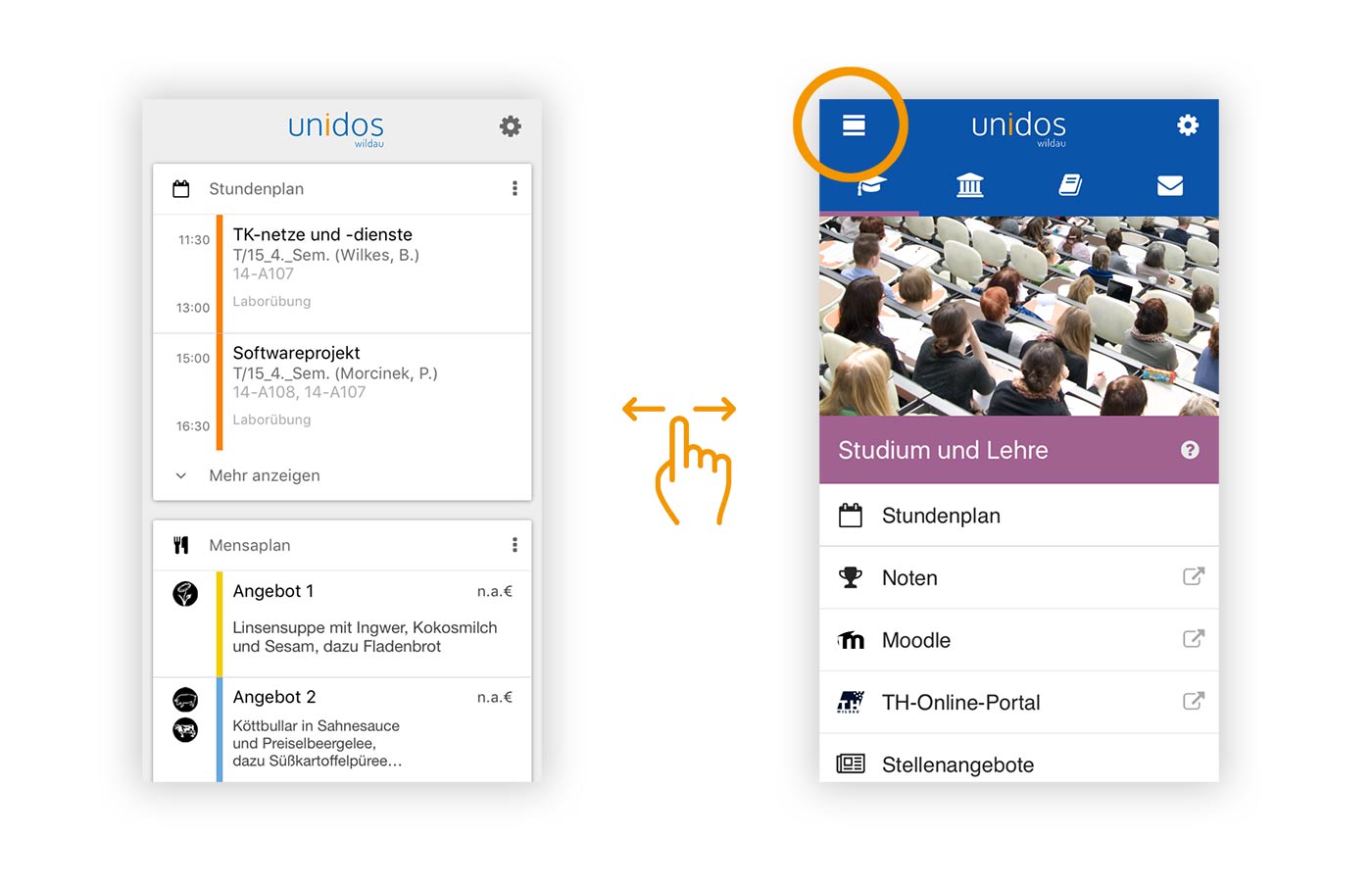

Unidos Wildau

UNIDOS WILDAU – ZUSAMMEN IM STUDI-ALLTAG

Unidos ist der perfekte Begleiter für den Alltag an der Technischen Hochschule in Wildau - nicht nur für Studierende und Mitarbeiter, auch für Besucher und Interessierte. In vier Rubriken gibt es Bibliotheksdienste, Stundenpläne, personalisierte Mitteilungen, Campusrundgang und vieles mehr.

Unidos Wildau ist ein Angebot von iCampus Wildau, ein Projekt zum Aufbau eines interaktiven Informationsraumes zur Erschließung virtueller Inhalte auf dem Hochschulcampus.

Funktionsübersicht

In der Rubrik Campus sind neben dem Mensaplan auch das iCampus-Portals und die mobile Einbindung der Campuserkundung zu finden, über die Besucher und Studierende mittels Touren und thematischen Filtern den Campus virtuell erkunden, und somit besser kennenlernen können.

Unter Bibliothek sind alle Funktionen aus der Vorgängerversion iLibrary integriert: Büchersuche und Bücherscanner, das Speichern von Favoriten, der Raumbelegungsplan sowie die personalisierte Übersicht über ausgeliehene Bücher und Erinnerungsnachrichten für die Buchabgabe.

In Studium und Lehre ist es möglich, ausgewählte Stundenpläne anzeigen zu lassen und diese direkt auf dem Mobilgerät zu speichern. Optional wird der Stundenplan in den Kalender importiert. Zudem können Prüfungsergebniss für ausgewählte Studiengänge abgerufen werden.

Unter Mitteilungen können Push-Nachrichten abonniert werden, die von Hochschuleinrichtungen direkt an die Nutzer gesendet werden. Nach dem Follower-Prinzip folgen Nutzer ausgewählten Kanälen. Je nach Interesse werden diese aktiviert oder deaktiviert.

UnidowNow

Mit der neuen Version von Unidos Wildau führen wir ein neues Feature ein, mit dem Nutzer einen besseren Überblick über einige der Hochschuldienste haben. Diese sind zur Zeit: Mensa, Stundenplan, ausgeliehene Bücher und Nachrichten.

Auf einen Blick sind die tagesaktuellen Informationen nur einen Wisch/Klick entfernt: anstehende Lehrveranstaltungen, abzugebene Bücher, das Mittagsessen von heute und ungelesene Meldungen.

Logbuch

Lorem ipsum dolor sit amet, consectetuer adipiscing elit. Aenean commodo ligula eget dolor. Aenean massa. Cum sociis natoque penatibus et magnis dis parturient montes, nascetur ridiculus mus. Donec quam felis, ultricies nec, pellentesque eu, pretium quis, sem. Nulla consequat massa quis enim.

Donec pede justo, fringilla vel, aliquet nec, vulputate eget, arcu. In enim justo, rhoncus ut, imperdiet a, venenatis vitae, justo. Nullam dictum felis eu pede mollis pretium. Integer tincidunt. Cras dapibus. Vivamus elementum semper nisi. Aenean vulputate eleifend tellus. Aenean leo ligula, porttitor eu, consequat vitae, eleifend ac, enim. Aliquam lorem ante, dapibus in, viverra quis, feugiat a, tellus. Phasellus viverra nulla ut metus varius laoreet. Quisque rutrum.

Aenean imperdiet. Etiam ultricies nisi vel augue. Curabitur ullamcorper ultricies nisi. Nam eget dui. Etiam rhoncus. Maecenas tempus, tellus eget condimentum rhoncus, sem quam semper libero, sit amet adipiscing sem neque sed ipsum. Nam quam nunc, blandit vel, luctus pulvinar, hendrerit id, lorem. Maecenas nec odio et ante tincidunt tempus. Donec vitae sapien ut libero venenatis faucibus. Nullam quis ante. Etiam sit amet orci eget eros faucibus tincidunt. Duis leo. Sed fringilla mauris sit amet nibh. Donec sodales sagittis magna. Sed consequat, leo eget bibendum sodales, augue velit cursus nunc

Lorem ipsum dolor sit amet, consectetuer adipiscing elit. Aenean commodo ligula eget dolor. Aenean massa. Cum sociis natoque penatibus et magnis dis parturient montes, nascetur ridiculus mus. Donec quam felis, ultricies nec, pellentesque eu, pretium quis, sem. Nulla consequat massa quis enim.

Donec pede justo, fringilla vel, aliquet nec, vulputate eget, arcu. In enim justo, rhoncus ut, imperdiet a, venenatis vitae, justo. Nullam dictum felis eu pede mollis pretium. Integer tincidunt. Cras dapibus. Vivamus elementum semper nisi. Aenean vulputate eleifend tellus. Aenean leo ligula, porttitor eu, consequat vitae, eleifend ac, enim. Aliquam lorem ante, dapibus in, viverra quis, feugiat a, tellus. Phasellus viverra nulla ut metus varius laoreet. Quisque rutrum.

Aenean imperdiet. Etiam ultricies nisi vel augue. Curabitur ullamcorper ultricies nisi. Nam eget dui. Etiam rhoncus. Maecenas tempus, tellus eget condimentum rhoncus, sem quam semper libero, sit amet adipiscing sem neque sed ipsum. Nam quam nunc, blandit vel, luctus pulvinar, hendrerit id, lorem. Maecenas nec odio et ante tincidunt tempus. Donec vitae sapien ut libero venenatis faucibus. Nullam quis ante. Etiam sit amet orci eget eros faucibus tincidunt. Duis leo. Sed fringilla mauris sit amet nibh. Donec sodales sagittis magna. Sed consequat, leo eget bibendum sodales, augue velit cursus nunc

Innovationspreis für Bibliotheken

Das Projekt NAO-Leseroboter gewinnt den Innovationspreis für Bibliotheken in Berlin und Brandenburg.

Modulhandbuch

Entwicklung des Modulhandbuch zur Verwaltung und Ausgabe der Studiengangsmodule an der TH Wildau.

openBeacon-Indoorortung in der TH Wildau Bibliothek

Indoorortung wird mit der Technologie openBeacon in der Hochschulbibliothek der TH Wildau eingesetzt und evaluiert.

Erste 360°-Campustour

Campusrundgänge mit 360°-Panoramabildern und Studiengangsinformationen werden als studentisches Projekt realisiert.

Seitennummerierung

- Vorherige Seite

- Seite 2

- Nächste Seite